[本站讯]10月2日,山东大学软件学院智能图形图像处理(Intelligent Graphics and Image Processing,简称IGIP)实验室在基于事件相机的眼动追踪领成果“RGBE-Gaze: A Large-scale Event-based Multimodal Dataset for High Frequency Remote Gaze Tracking”被人工智能领域顶级期刊IEEE Transactions on Pattern Analysis and Machine Intelligence (TPAMI)接收,TPAMI是计算机学会(CCF)推荐人工智能领域A类顶级期刊,影响因子IF=20.8,在人工智能领域享有很高的声誉。

本文的第一作者和通讯作者单位均为山东大学软件学院,其中第一作者为山东大学软件学院IGIP实验室的在读博士生赵广荣,指导教师为沈益冉教授和周元峰教授。软件学院研究生张晨龙,本科生沈钊鑫,英国华威大学教授温宏凯等合作者也均作出了重要贡献。

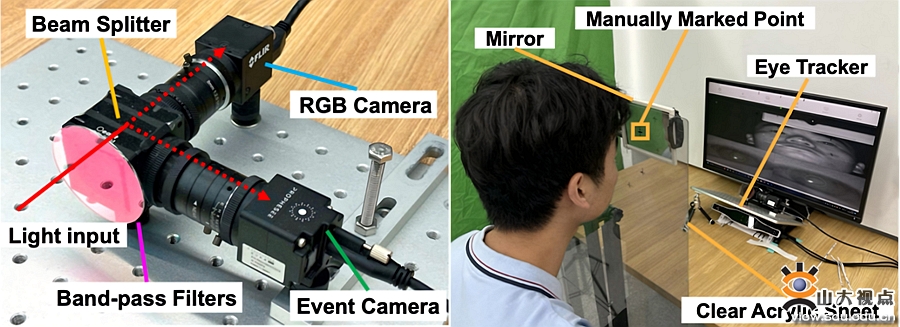

在本研究中,作者提出了RGBE-Gaze,首个通过同步RGB和事件相机进行高频率远程视线追踪的大规模多模态数据集。该数据集来自66名不同性别和年龄组的参与者。实验室利用定制的RGB-事件相机系统收集了360万张高空间分辨率的全脸RGB图像和2630亿个高时间分辨率的事件样本。此外,数据集还包括1070万个来自Gazepoint GP3 HD眼动仪的视线参考点,以及通过参与者手动点击刺激获得的15972个稀疏视线(PoG)地面真值点。作者使用该数据集进行了大量的实验,展示了数据集在头部姿态与距离、视线方向、瞳孔大小和追踪频率等特征上的分布情况。此外,作者还提出了一种基于帧-事件混合的视线估计方法,专门为所收集的数据集设计。最后,作者对该方法以及现有的基于帧的视线估计方法在不同的视线相关因素下进行了广泛的评估,包括不同的受试者、视线方向、头部姿态、头部距离和瞳孔直径。评估结果表明,将事件流作为新模态引入数据集提高了视线追踪频率,并在多种视线相关因素下表现出了更强的估计鲁棒性。

该数据集主要用于超高速眼动追踪算法的研究。超高速眼动追踪是支持虚拟现实环境的注视点渲染、心理诊疗、身份认证等元宇宙领域重要应用的技术基础。